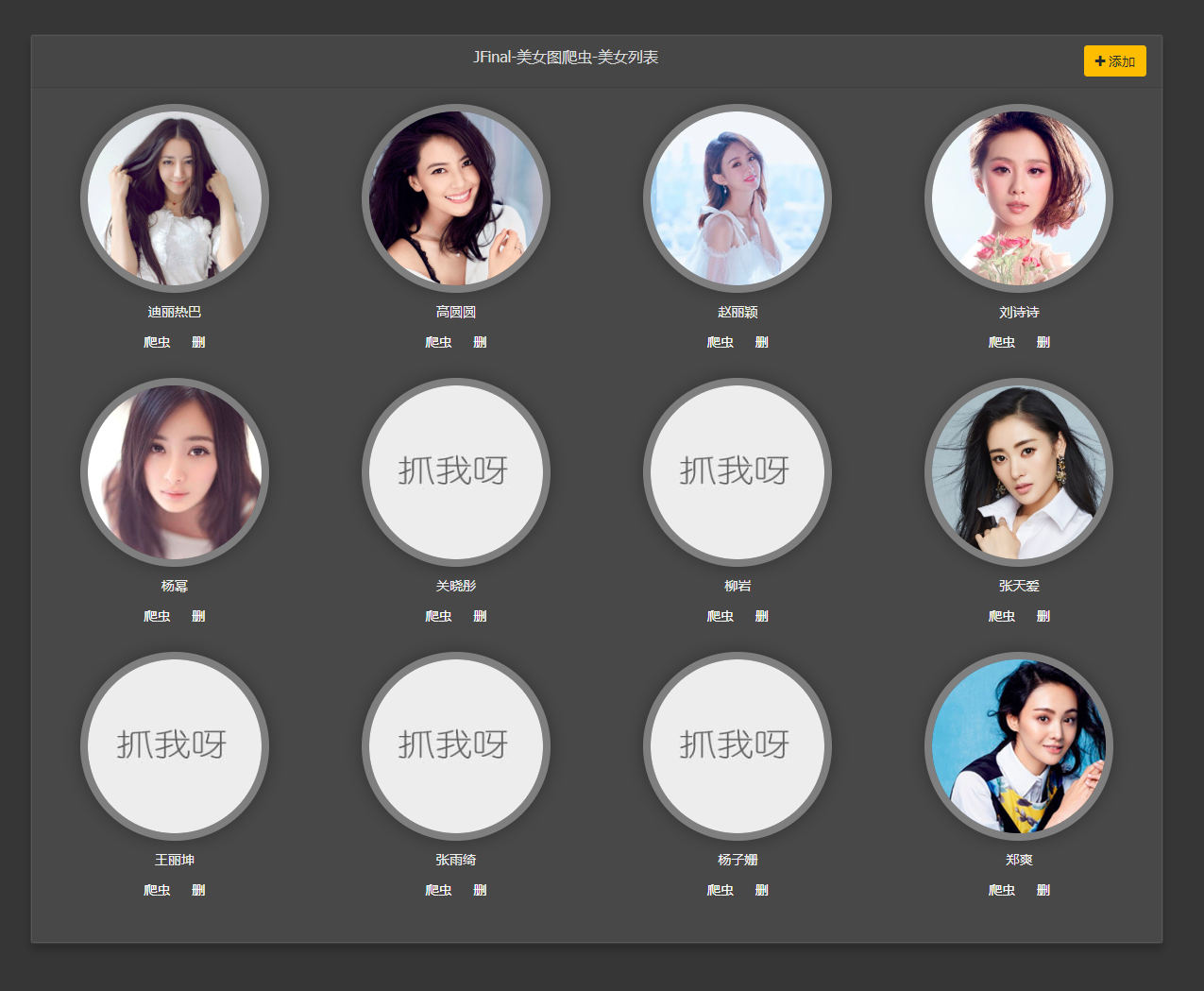

去年,做了几个JFinal项目,大量使用了Java爬虫去全网抓取数据,清洗筛选后入库,成为本地结构化数据。

Java中JSOUP做HTML解析是最好的工具,没有之一。

之前听过一句话,大体意思就是

我们所能访问的网页本身就是一个数据宝藏,天然的对外数据接口。

只要我们能拿到网页的Html代码,就可以拿到网站的公开数据。

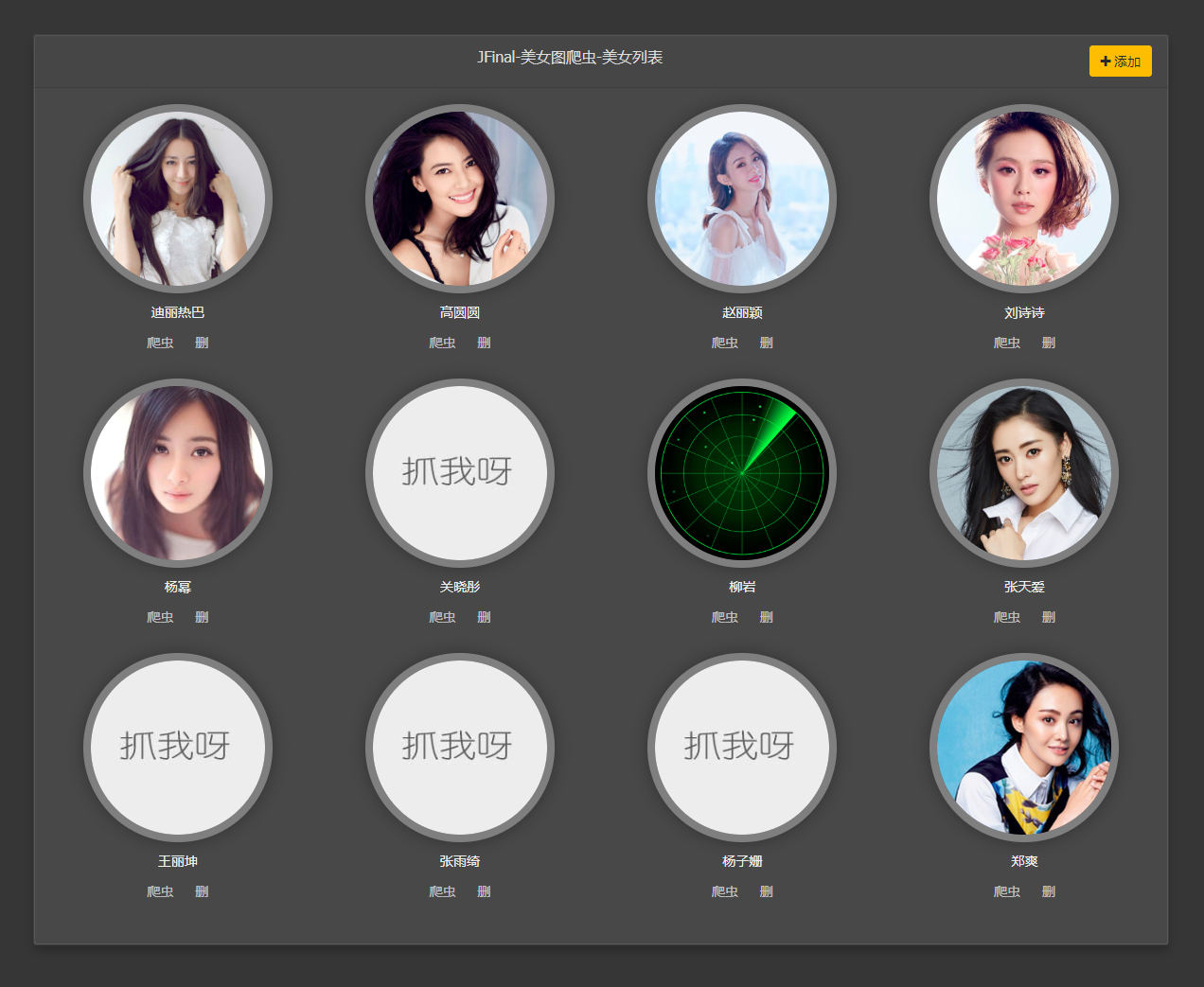

【雷达启动,正在扫描】

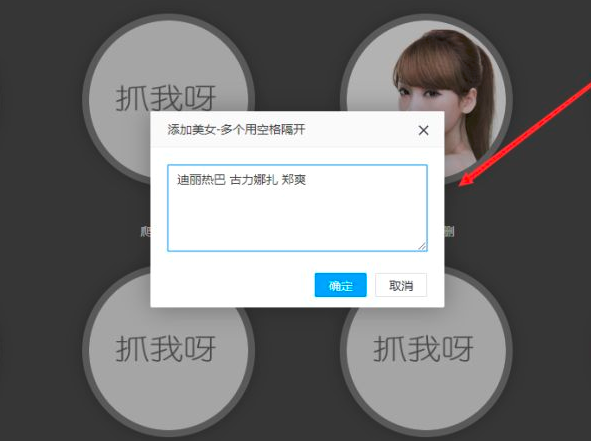

【可以快速添加明星】

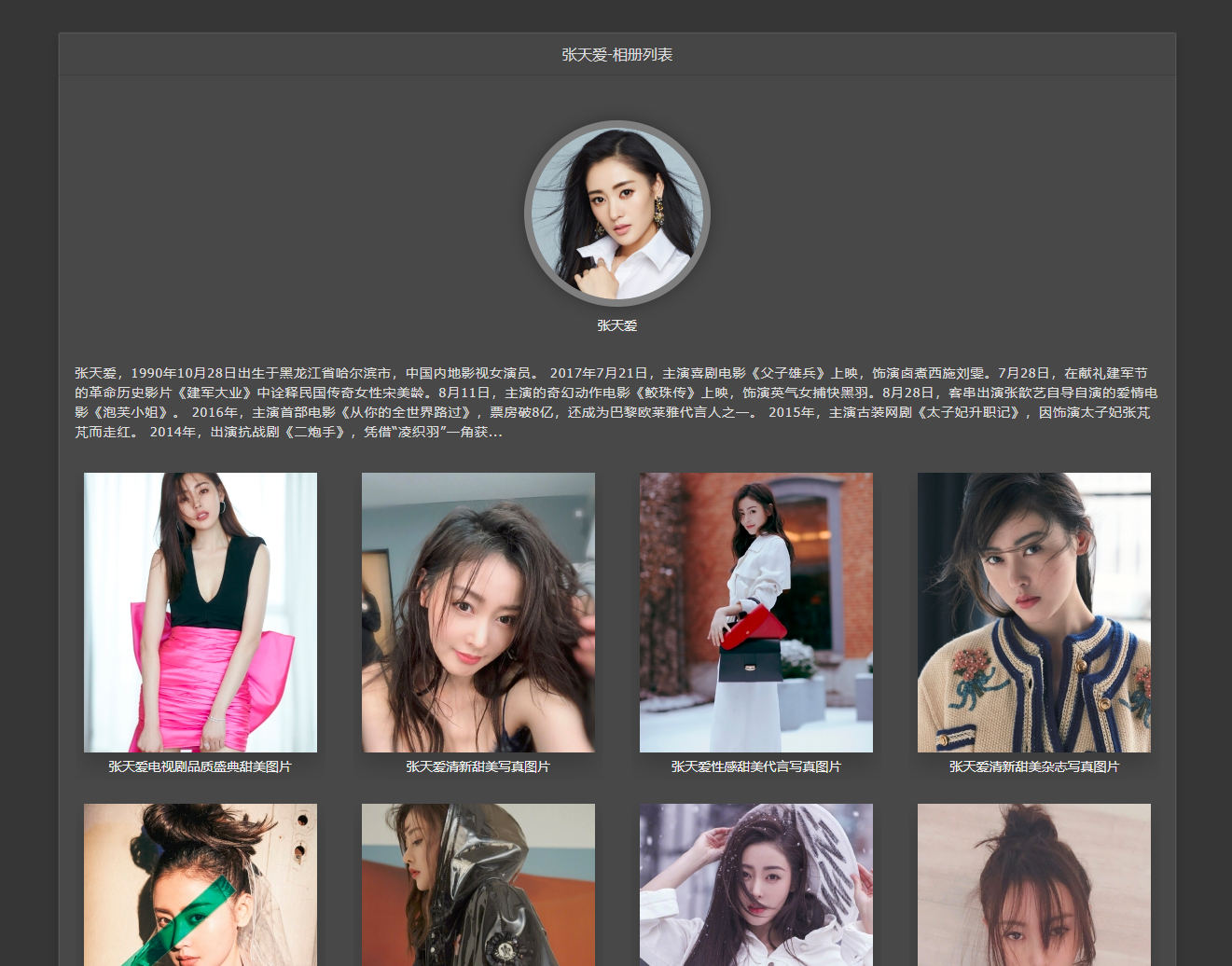

【个人相册主页】

【相册里的照片】

【点一张出来幻灯片】

【大图单页】

代码使用技术

JFinal

JFinal Undertow

Bootstrap

JQuery

Layer

JSoup

Mysql

Jbolt

利用JSoup针对直接加载显示数据的网页,也可以轻松拿到Html代码,后面的操作类似JQuery的API,有这类似的DOM操作形式。

还可以扩展爬虫的能力,分布式,多线程,异步,定时任务执行,总之,了解和核心使用方法,剩下的都是怎么玩儿的事儿了!

代码获取方式:

扫码识别

关注JFinal学院公众号

回复:“爬虫”两个字